Deepfake - hiểm họa và mặt trái của trí tuệ nhân tạo

Thời gian gần đây, tội phạm công nghệ cao đang lợi dụng sự phát triển của trí tuệ nhân tạo để nâng cấp thủ đoạn, phương thức phạm tội tinh vi, xảo quyệt hơn. Những thủ đoạn này đã vượt qua giới hạn cảnh giác của nhiều người, gây ra nhiều mối lo ngại với hệ thống an ninh thông tin toàn cầu.

Cuộc gọi thật nhưng hình nhân vật là giả

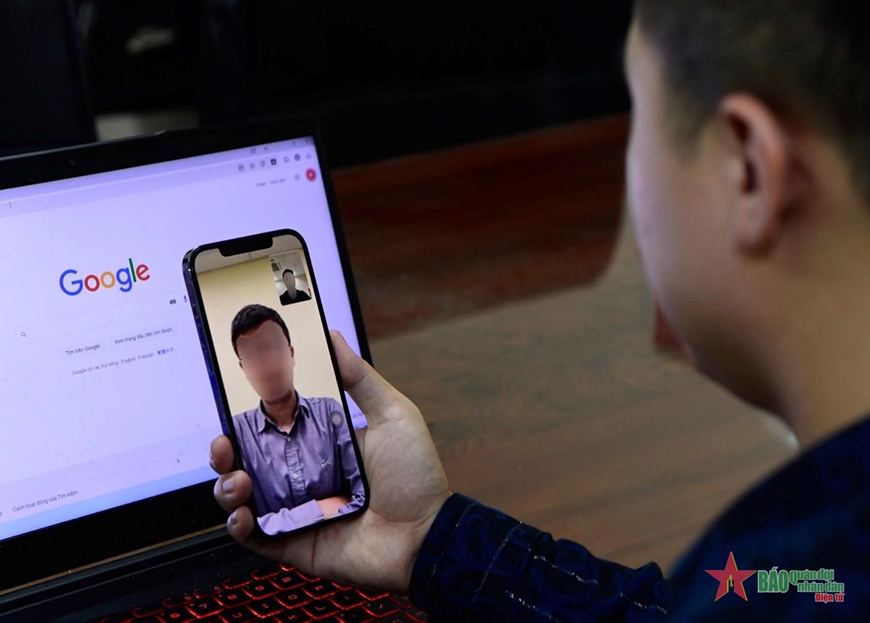

Nếu bạn nhận được cuộc gọi hình ảnh (video call) từ một người thân hoặc bạn bè thì đừng vội tin tưởng làm theo những yêu cầu của người đó, vì rất có thể bạn đang là nạn nhân của hoạt động lừa đảo với mục đích chiếm đoạt tài sản. Tất cả hình ảnh, video về người thân, bạn bè của bạn đều là giả, được tạo ra bởi công nghệ trí tuệ nhân tạo. Deepfake chính là một trong số các tác giả của những sản phẩm đó.

Deepfake thực chất là một phần mềm sử dụng trí tuệ nhân tạo để mô phỏng lại hình dáng, giọng nói, cử chỉ của con người; có thể tạo ra những hình ảnh, đặc biệt là những đoạn video giống một người nào đó, từ cử chỉ đến lời nói. Ứng dụng này ra đời với mục đích ban đầu là giải trí, tuy nhiên, các đối tượng tội phạm đã lợi dụng Deepfake như một vũ khí lợi hại để thực hiện các hành vi lừa đảo, chiếm đoạt tài sản, bôi nhọ danh dự, dẫn dắt dư luận...

Hoạt động lừa đảo qua các ứng dụng OTT (Zalo, Facebook, Skype, Telegram...) đã trở nên phổ biến trong những năm gần đây. Ban đầu, đối tượng tội phạm sẽ đánh cắp các tài khoản cá nhân để thực hiện lừa đảo như nhắn tin vay tiền với những lý do, hoàn cảnh khác nhau. Sau một thời gian, nhận thấy hoạt động này đã kém hiệu quả do người dân chủ động cảnh giác, tội phạm công nghệ cao đã nâng cấp thủ đoạn lên một mức độ mới, tinh vi và xảo quyệt hơn, đó là kết hợp giữa chiếm đoạt tài khoản cá nhân và sử dụng Deepfake để thực hiện cuộc gọi hình ảnh. Nhìn thấy người thân, bạn bè đang nói chuyện với mình, nhiều người sẽ không thể tin được đây chỉ là ảo ảnh do công nghệ tạo ra và việc bị lừa là khó tránh khỏi.

|

| Người dân cần cảnh giác với cuộc gọi hình ảnh có dấu hiệu bất thường. |

Bên cạnh đó, công nghệ Deepfake còn đang gây ra mối lo ngại toàn cầu về an ninh, an toàn xã hội. Tội phạm công nghệ cao sẽ sử dụng những hình ảnh, video giả mạo để bôi nhọ danh dự cá nhân, tổ chức nhằm mục đích tống tiền, hạ uy tín; đặc biệt, chúng sử dụng hình ảnh giả mạo những người có tầm ảnh hưởng xã hội để tạo hiệu ứng đám đông, dẫn dắt dư luận, gây mất an ninh trật tự xã hội.

Có thể nhận biết dấu hiệu lừa đảo

Tuy nhiên, Deepfake chưa đạt đến mức độ hoàn hảo. Theo các chuyên gia thì các cuộc gọi Deepfake vẫn có một số dấu hiệu để nhận biết như: Thời gian gọi thường rất ngắn, chỉ vài giây. Khuôn mặt của người trong video thiếu cảm xúc và khá cứng khi nói, hoặc tư thế của họ trông lúng túng, không tự nhiên, hướng đầu và cơ thể của họ trong video không nhất quán với nhau. Ngoài ra, cũng có thể thấy màu da của nhân vật trong video bất thường, ánh sáng kỳ lạ và bóng đổ không đúng vị trí. Điều này có thể khiến cho video trông rất giả tạo và không tự nhiên. Âm thanh có thể không đồng nhất với hình ảnh, có nhiều tiếng ồn bị lạc vào clip hoặc clip không có âm thanh. Vì cuộc gọi Deepfake thường có thời gian rất ngắn nên các đối tượng lừa đảo sẽ lấy lý do sóng kém, sau đó tiếp tục nhắn tin đề nghị nạn nhân làm theo yêu cầu (chủ yếu là lừa chuyển tiền vào tài khoản ngân hàng).

Theo ông Trần Quang Hưng, Phó cục trưởng Cục An toàn thông tin (Bộ Thông tin và Truyền thông), hoạt động lừa đảo trên mạng chủ yếu là lừa đảo tài chính, để chiếm đoạt tài chính thì phải có những tài khoản ngân hàng để chuyển tiền vào. Hiện vẫn còn những tài khoản ngân hàng không chính chủ, có thể thực hiện mua bán dễ dàng trên internet. Nghị định số 13/2023/NĐ-CP về bảo vệ dữ liệu cá nhân được ban hành ngày 17-4-2023 là căn cứ để xử lý triệt để tài khoản ngân hàng không chính chủ, góp phần giảm thiểu hành vi lừa đảo trực tuyến.

Ông Trần Quang Hưng cho biết, cuộc chiến chống lừa đảo trên không gian mạng là cuộc chiến trường kỳ, cần sự phối hợp chặt chẽ giữa các cơ quan liên quan như Bộ Thông tin và Truyền thông, Bộ Công an, Ngân hàng Nhà nước, cơ quan báo chí-truyền thông để xử lý nghiêm khắc kết hợp tuyên truyền nâng cao nhận thức, giúp ngăn chặn hoạt động lừa đảo trên mạng, đó mới là biện pháp căn cơ. Vì nếu chỉ thực hiện các biện pháp xử lý về công nghệ thì không thể triệt để, do công nghệ có thể thay đổi và phát triển rất nhanh. Bên cạnh đó, cần tiếp tục đồng bộ các thông tin thuê bao với Cơ sở dữ liệu quốc gia về dân cư.

Theo các chuyên gia về công nghệ, người dân có thể dựa vào các đặc điểm được cơ quan chức năng đưa ra để tiếp tục nâng cao cảnh giác. Khi nhận được các cuộc gọi video có dấu hiệu của Deepfake, người dân cần bình tĩnh, không vội vàng chuyển tiền hay cung cấp thông tin theo yêu cầu, cùng với đó, người dân nên gọi lại để kiểm tra, cố gắng kéo dài cuộc gọi (1-2 phút) hoặc đặt ra một số câu hỏi cá nhân, trí tuệ nhân tạo trên Deepfake chưa đạt độ hoàn hảo nên sẽ không thể xử lý tình huống giống hệt người thật.

Trí tuệ nhân tạo ra đời như một bước phát triển vượt bậc của ngành khoa học-công nghệ, tuy nhiên, đây cũng giống như con dao hai lưỡi, nếu dùng đúng mục đích, trí tuệ nhân tạo sẽ có những đóng góp to lớn cho tất cả lĩnh vực trong xã hội. Tuy nhiên, nếu bị các đối tượng tội phạm sử dụng thì sẽ rất nguy hiểm. Người dân nên hạn chế chia sẻ hình ảnh, video, thông tin cá nhân trên các nền tảng mạng xã hội, vì đây sẽ là kho dữ liệu khổng lồ để tội phạm công nghệ cao khai thác và sử dụng để huấn luyện trí tuệ nhân tạo thực hiện hành vi sao chép.

Bài và ảnh: HOÀNG CHUNG